Stability AI推出12B参数Stable LM 2模型和更新的1.6B变体

Stability AI已推出其Stable LM 2语言模型系列的最新成员:一个120亿参数的基础模型和一个经过指令调优的变体。这些模型在七种语言上训练,包括英语、西班牙语、德语、意大利语、法语、葡萄牙语和荷兰语,训练数据达到了令人印象深刻的两万亿个标记。

120亿参数的模型旨在在强大的性能、效率、内存需求和速度之间找到平衡。它遵循了Stability AI之前发布的Stable LM 2 1.6B技术报告的既定框架。这一新版本扩展了公司的模型范围,为开发者提供了一个透明而强大的工具,用于用AI语言技术进行创新。

除了12B模型,Stability AI还发布了其Stable LM 2 1.6B模型的新版本。这个更新的1.6B变体在相同的七种语言上改善了对话能力,同时保持了极低的系统要求。

Stable LM 2 12B被设计为一个高效的开放模型,专为多语言任务量身定做,能在广泛可用的硬件上平稳运行。

据Stability AI称,这个模型能够处理通常只有大得多的模型才能完成的任务,这些大模型通常需要大量的计算和内存资源,比如大型的专家混合模型(Mixture-of-Experts, MoEs)。指令调优版本特别适合各种用途,包括作为检索RAG系统的中心部分,因为它在工具使用和功能调用方面的性能很高。

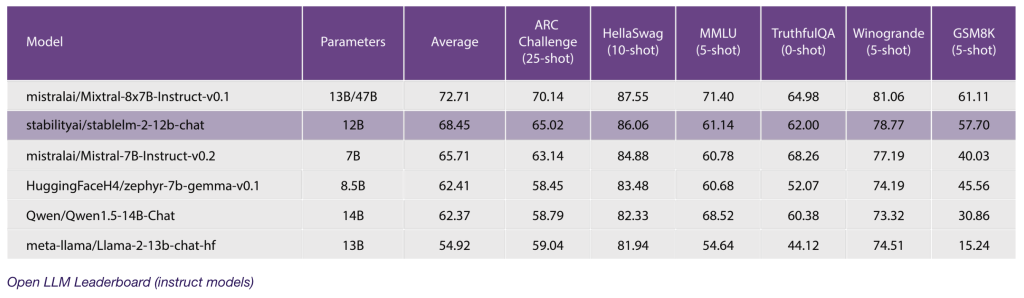

在与Mixtral、Llama2、Qwen 1.5、Gemma和Mistral等流行的强大语言模型的性能比较中,Stable LM 2 12B在Open LLM排行榜概述的零样本和少样本任务上提供了可靠的结果:

通过这一新发布,Stability AI将StableLM 2系列扩展到了12B类别,提供了一个开放透明的模型,而不牺牲功效和准确性。该公司有信心,这一发布将使开发者和企业能够继续开发未来,同时完全控制他们的数据。

开发者和企业现在可以通过Stability AI会员资格,将Stable LM 2 12B用于商业和非商业目的。